부분적으로 붕괴된 갱도에 갇힌 작업자를 찾는 로봇은 현장 지도를 빠르게 생성하고 위험한 지형을 탐색하는 동안 현장 내 위치를 식별해야 합니다.

연구자들은 최근 로봇에 탑재된 카메라의 이미지만을 사용하여 이 복잡한 작업을 수행하기 위해 강력한 기계 학습 모델을 구축하기 시작했지만 최고의 모델이라도 한 번에 몇 개의 이미지만 처리할 수 있습니다. 매 순간이 중요한 실제 재난 상황에서 수색 및 구조 로봇은 임무를 완수하기 위해 넓은 지역을 빠르게 횡단하고 수천 장의 이미지를 처리해야 합니다.

이 문제를 극복하기 위해 MIT 연구원들은 최신 인공 지능 비전 모델과 기존 컴퓨터 비전의 아이디어를 바탕으로 임의 개수의 이미지를 처리할 수 있는 새로운 시스템을 개발했습니다. 그들의 시스템은 혼잡한 사무실 복도와 같은 복잡한 장면의 3D 지도를 몇 초 만에 정확하게 생성합니다.

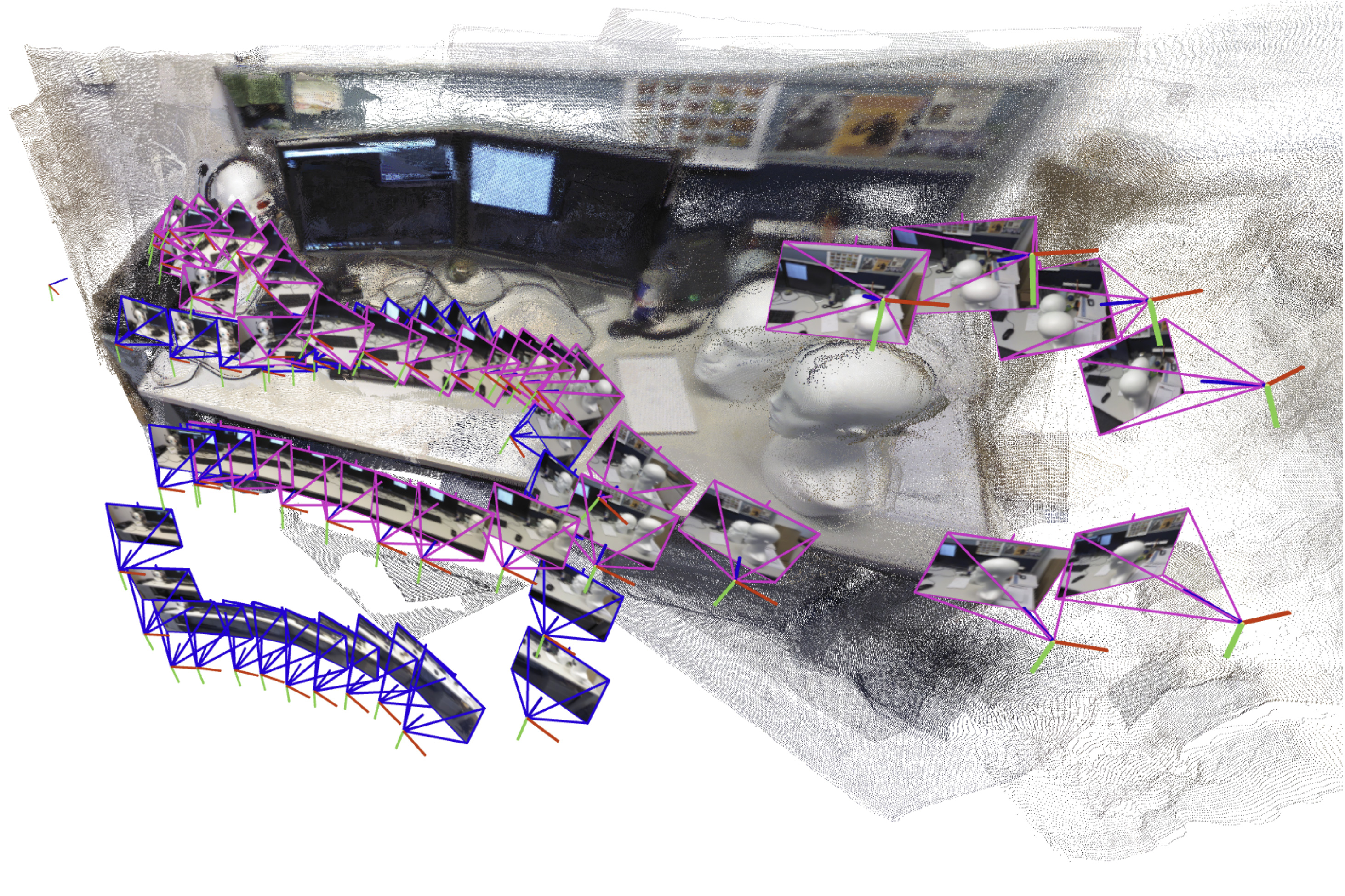

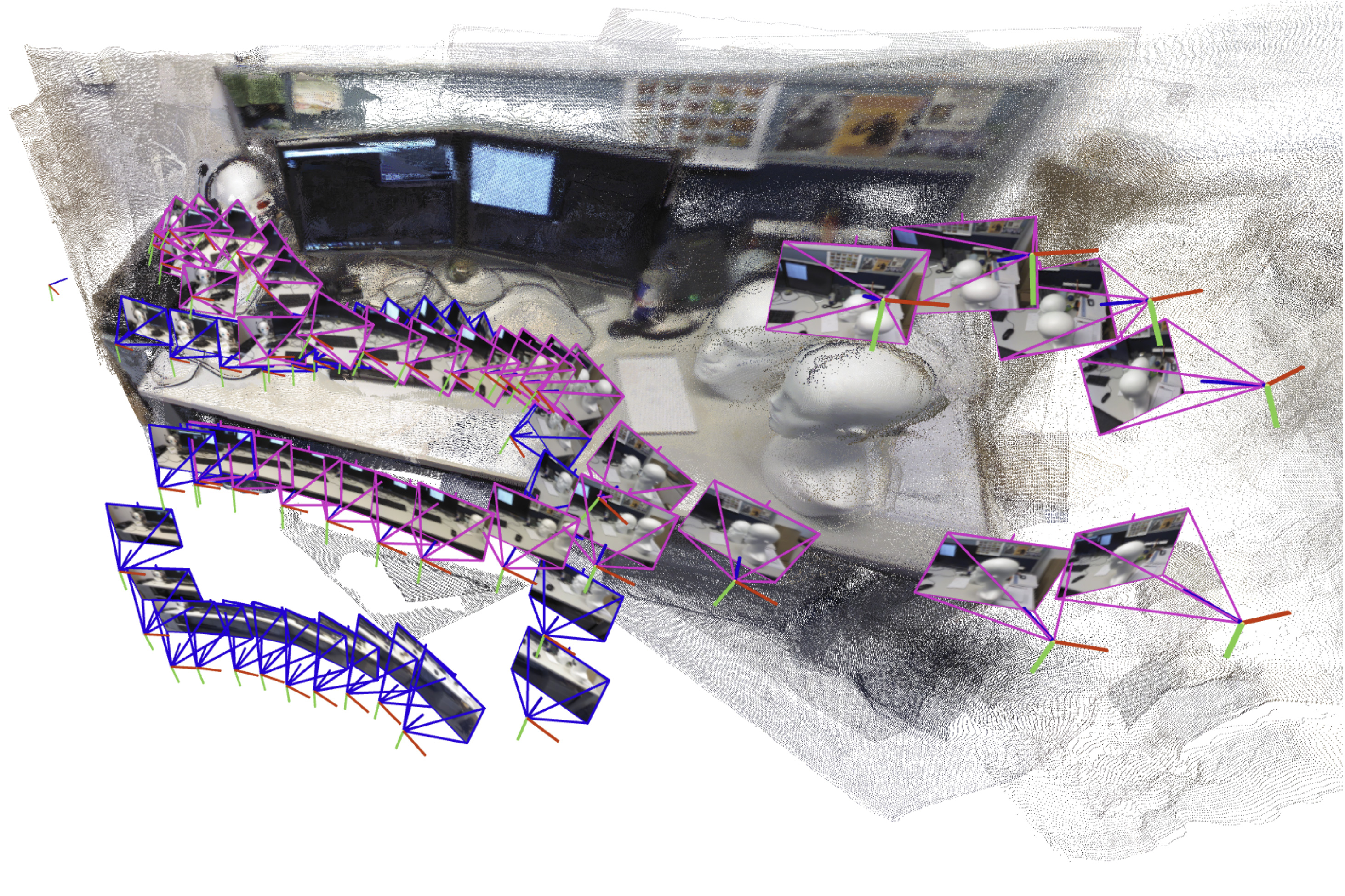

AI 기반 시스템은 장면의 작은 서브맵을 순차적으로 생성하고 정렬한 다음 서로 연결되어 전체 3D 맵을 재구성하고 로봇의 위치를 실시간으로 추정합니다.

다른 많은 접근 방식과 달리 이 기술에는 복잡한 시스템 구현을 조정하기 위해 보정된 카메라나 전문가가 필요하지 않습니다. 3D 재구성의 속도 및 품질과 결합된 접근 방식의 단순한 특성을 통해 실제 응용 분야에 맞게 확장하기가 쉽습니다.

이 방법은 수색 및 구조 로봇의 탐색을 돕는 것 외에도 VR 헤드셋과 같은 웨어러블 장치를 위한 확장 현실 애플리케이션을 만들거나 산업용 로봇이 창고 내에서 상품을 빠르게 찾아 이동할 수 있도록 하는 데 사용될 수 있습니다.

“로봇이 점점 더 복잡한 작업을 수행하려면 주변 세계에 대한 더 복잡한 지도 표현이 필요합니다. 그러나 동시에 우리는 실제로 이러한 지도를 구현하는 것을 더 어렵게 만들고 싶지 않습니다. 우리는 즉시 사용 가능한 도구를 사용하여 몇 초 만에 정확한 3D 재구성을 생성하는 것이 가능하다는 것을 보여주었습니다”라고 MIT 대학원생이자 이 방법에 대한 논문의 주요 저자인 Dominic Maggio는 말합니다.

Maggio에는 임흥태 박사후 연구원과 수석 저자인 Luca Carlone, MIT 항공우주학과(AeroAstro) 부교수, LIDS(정보 및 결정 시스템 연구소)의 수석 연구원, MIT SPARC 연구소 소장이 합류했습니다. 이 연구는 신경정보처리시스템 컨퍼런스에서 발표될 예정이다.

솔루션 매핑

수년 동안 연구자들은 SLAM(동시 위치 파악 및 매핑)이라는 로봇 내비게이션의 필수 요소와 씨름해 왔습니다. SLAM에서 로봇은 공간 내에서 방향을 지정하면서 주변 환경의 지도를 재구성합니다.

이 작업을 위한 기존 최적화 방법은 까다로운 장면에서는 실패하거나 사전에 로봇의 온보드 카메라를 보정해야 합니다. 이러한 함정을 피하기 위해 연구자들은 기계 학습 모델을 훈련하여 데이터에서 이 작업을 학습합니다.

구현하기 쉽지만 최고의 모델이라도 한 번에 약 60개의 카메라 이미지만 처리할 수 있으므로 로봇이 수천 개의 이미지를 처리하면서 다양한 환경에서 빠르게 이동해야 하는 애플리케이션에는 실용적이지 않습니다.

이 문제를 해결하기 위해 MIT 연구진은 전체 맵 대신 장면의 작은 하위 맵을 생성하는 시스템을 설계했습니다. 그들의 방법은 이러한 서브맵을 전체 3D 재구성으로 “접착”합니다. 모델은 여전히 한 번에 몇 개의 이미지만 처리하지만 시스템은 더 작은 서브맵을 함께 결합하여 더 큰 장면을 훨씬 빠르게 재구성할 수 있습니다.

Maggio는 “매우 간단한 해결책처럼 보였지만 처음 시도했을 때 그다지 잘 작동하지 않는다는 사실에 놀랐습니다.”라고 말합니다.

설명을 찾기 위해 그는 1980년대와 1990년대의 컴퓨터 비전 연구 논문을 샅샅이 뒤졌습니다. 이 분석을 통해 Maggio는 머신 러닝 모델이 이미지를 처리하는 방식의 오류로 인해 서브맵 정렬 문제가 더 복잡해진다는 사실을 깨달았습니다.

기존 방법은 정렬될 때까지 회전 및 변환을 적용하여 서브맵을 정렬합니다. 그러나 이러한 새 모델은 서브맵에 약간의 모호함을 가져오기 때문에 정렬하기가 더 어려워질 수 있습니다. 예를 들어, 공간 한쪽의 3D 서브맵에는 약간 구부러지거나 확장된 벽이 포함될 수 있습니다. 단순히 이러한 왜곡된 서브맵을 회전하고 이동하여 정렬하는 것은 작동하지 않습니다.

Carlone은 “서로 잘 정렬될 수 있도록 모든 서브맵이 일관된 방식으로 왜곡되도록 해야 합니다.”라고 설명합니다.

보다 유연한 접근 방식

연구원들은 고전적인 컴퓨터 비전의 아이디어를 빌려 이러한 서브맵의 모든 왜곡을 표현할 수 있는 보다 유연하고 수학적 기술을 개발했습니다. 각 서브맵에 수학적 변환을 적용함으로써 보다 유연한 이 방법을 사용하면 모호성을 해결하는 방식으로 서브맵을 정렬할 수 있습니다.

입력 이미지를 기반으로 시스템은 장면의 3D 재구성과 카메라 위치 추정치를 출력하며, 로봇은 이를 사용하여 공간에서 위치를 파악합니다.

Carlone은 “Dominic이 학습 기반 접근 방식과 기존 최적화 방법이라는 두 가지 세계를 연결하는 직관을 갖게 되자 구현이 매우 간단해졌습니다.”라고 말했습니다. “이렇게 효과적이고 간단한 것은 많은 응용 가능성이 있습니다.

데이터를 처리하기 위해 특수 카메라나 추가 장비가 필요하지 않으며, 해당 시스템은 다른 방법보다 재구성 오류가 적고 더 빠르게 작동합니다. 연구원들은 휴대폰으로 캡처한 짧은 비디오만을 사용하여 MIT 예배당 내부와 같은 복잡한 장면을 거의 실시간으로 3D로 재구성했습니다.

이러한 3D 재구성의 평균 오류는 5cm 미만이었습니다.

앞으로 연구원들은 특히 복잡한 장면에서 자신의 방법을 더욱 신뢰할 수 있게 만들고 이를 까다로운 환경의 실제 로봇에 적용하기 위해 노력하고 있습니다.

Carlone은 “전통적인 기하학에 대해 아는 것이 도움이 됩니다. 모델에서 무슨 일이 일어나고 있는지 깊이 이해하면 더 나은 결과를 얻고 확장성을 높일 수 있습니다.”라고 말합니다.

이 연구는 미국 국립과학재단, 미국 해군연구청, 한국국립연구재단의 일부 지원을 받습니다. 현재 Amazon Scholar로 안식년을 보내고 있는 Carlone은 Amazon에 합류하기 전에 이 작업을 완료했습니다.